10 多层感知机 + 代码实现

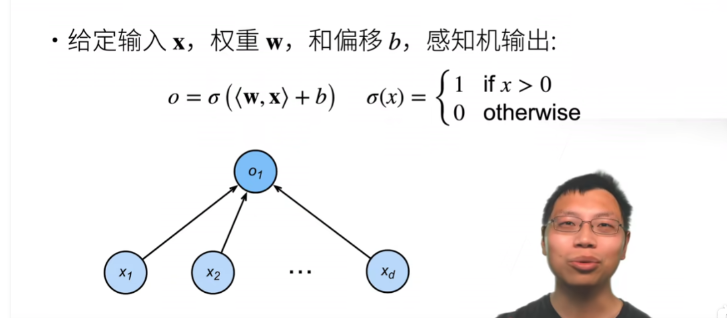

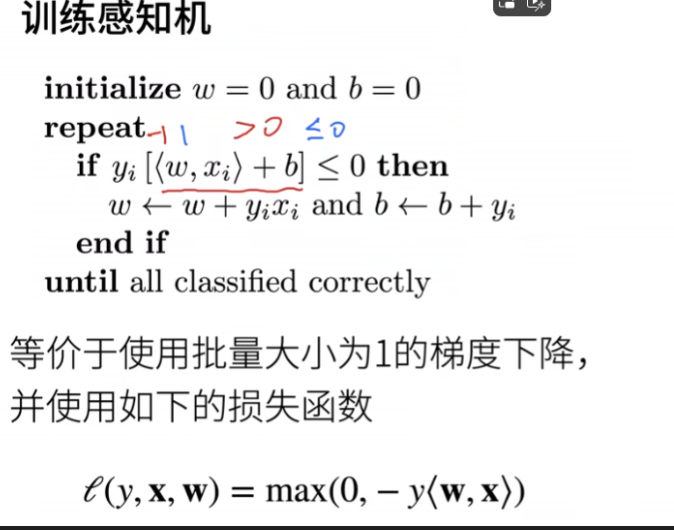

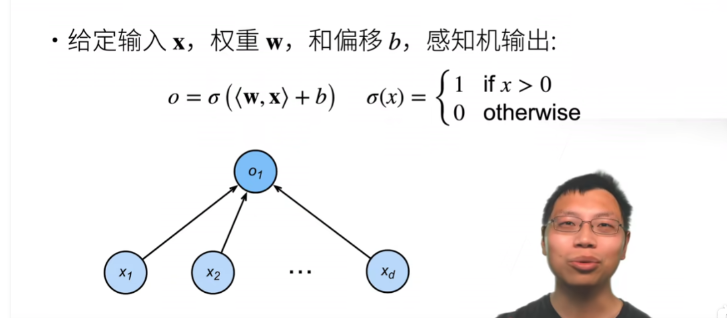

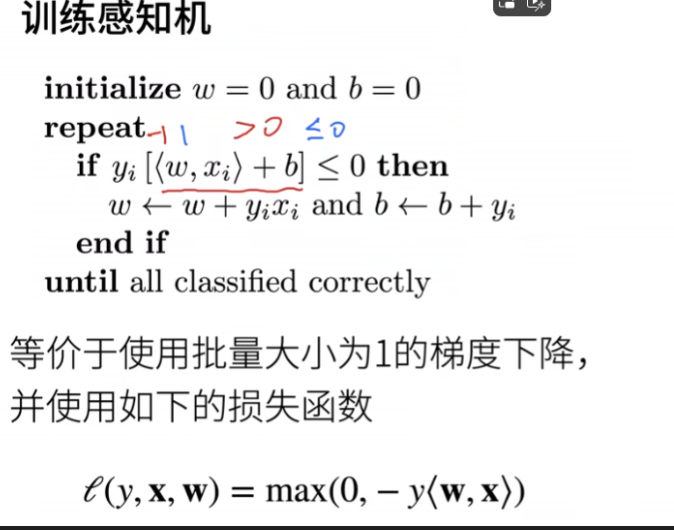

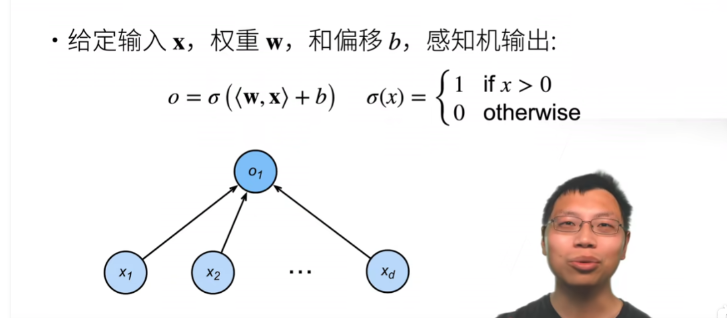

- 单层感知机

- 和线性回归相比:它的输出是不离散的

- 和softmax回归相比:它要解决二分类问题

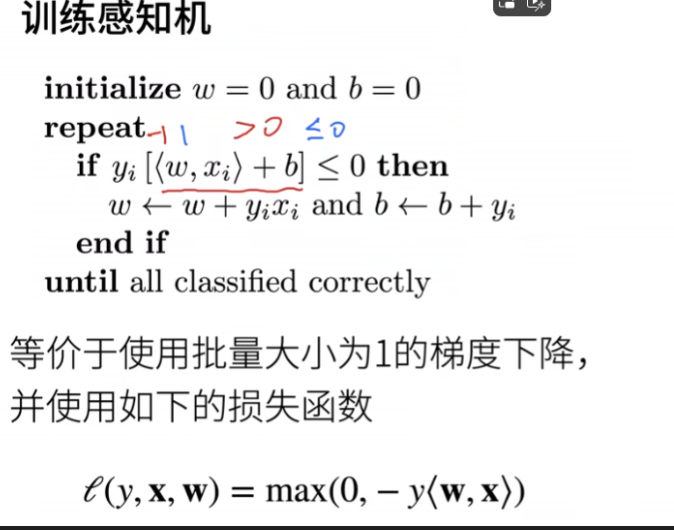

- 算法

- 超参数:隐藏层输出大小

- 局限:不能满足XOR问题

- 多层感知机(隐藏层的激活函数一定要是非线性的,否则就等价于单层感知机)

- 单隐藏层,单分类(输出就一个神经元)

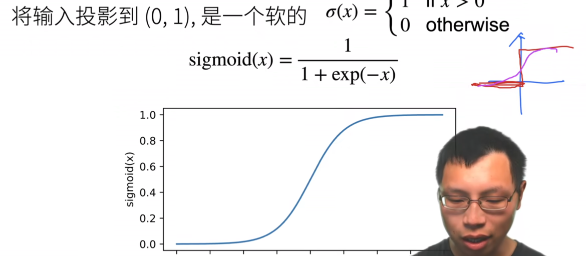

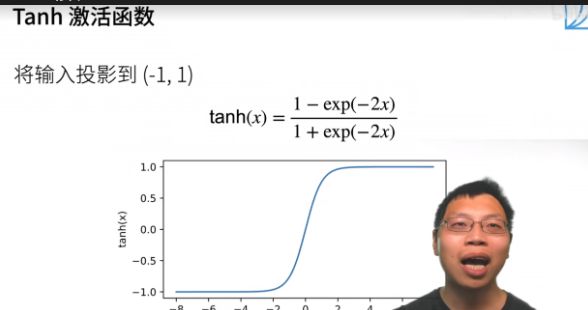

- 激活函数:

- sigmoid——区别就在于sigmoid函数比较平滑,因此称作软的

- tanh函数

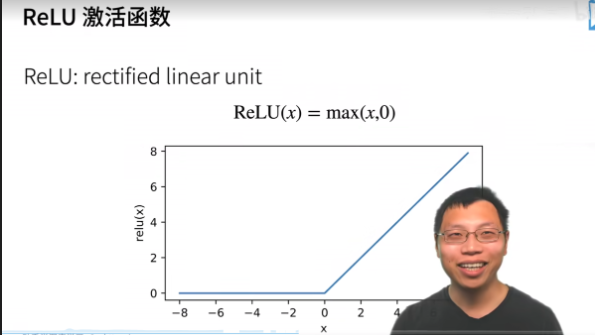

- relu函数

- 三个激活函数的对比:relu运算最简单,而sigmoid和tanh函数都有指数运算。在CPU里做一次指数运算相当于算100次乘法运算;而GPU里面有专门的指数计算单元,所以好一点

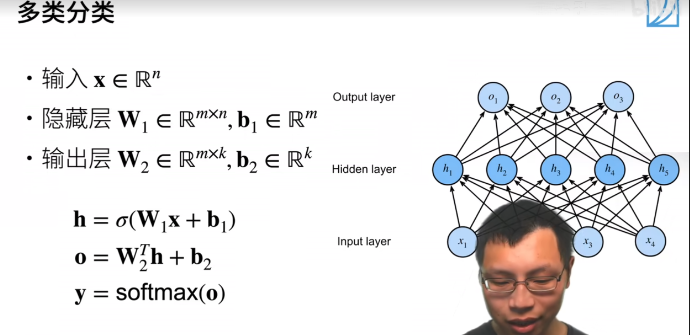

- 多分类

- 和softmax回归的对比:mlp加了隐藏层和非线性激活函数

- 超参数:隐藏层层数和每层隐藏层的输出大小

References

🔗10 多层感知机 + 代码实现 - 动手学深度学习v2_哔哩哔哩_bilibili